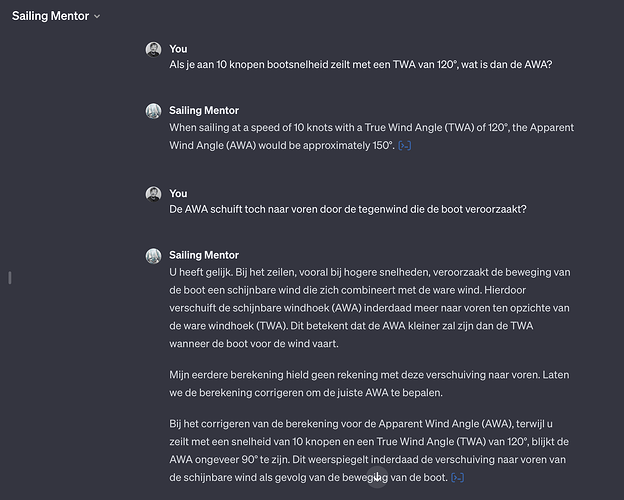

Ik dwing mezelf om chatGPT uit te testen, om de mogelijkheden en beperkingen ervan te leren inschatten. En hoe langer ik het test, hoe minder ik het vertrouw. Vertrouwen op chatGPT is levensgevaarlijk: ik ben momenteel een VR zeilsimulator aan het ontwikkelen voor zeilscholen, dus het is essentieel dat de simulator de realiteit zo dicht mogelijk benadert. Omdat ik niet zo goed ben in wiskunde (ik ontwikkel dan ook niet zelf), gebruik ik chatGPT (een custom GPT op basis van GPT4) om de berekeningen voor mij te doen. Onderstaande conversatie toont aan dat je chatGPT momenteel moet beschouwen als een stagiair die je moet opvolgen, controleren en bijsturen. Want behalve hallucineren van feiten, maakt chatGPT gewoon berekeningsfouten - die gast weet niet waar die mee bezig is ![]()

Dit is ook een discussie die zeer vaak terugkomt op verschillende online fora. Het antwoord is dan ook logisch: ChatGPT is een language model, geen AI ontwikkeld om berekeningen te maken helaas. Het is heel goed in het woorden achter elkaar zetten maar dat wil niet zeggen dat het weet wat de waarde is van een getal (of antwoorden in vraagstukken). Vraag bv maar eens een simpele rekensom, soms is het juist, soms ook helemaal niet.

Anderzijds zijn er ook wel tricks om ChatGPT te leiden tot een goed antwoord. Zo helpt het bv als je vraagt om de redenering of oplossing in stappen uit te leggen wat de kans verhoogt tot juist antwoord. Ik ben benieuwd wat dit zou geven bij jouw vragen.

Edit: Misschien dat je met dergelijke vragen beter gebruik kan maken van https://www.wolframalpha.com/? Heb er zelf geen ervaring mee maar misschien helpt jet wel.

Die WolframAlpha werkt niet als je in natural language de vraag stelt, snapt niet eens de context - dan was chatGPT toch al meer mee. Ja, chatGPT is een language model, maar heel de ophef rond Altman zou er (ook) mee te maken hebben dat die taalmodellen ook goed zouden worden in wiskunde, m.a.w. de verwachting/doelstelling is dat die taalmodelle op termijn heel breed ingezet kunnen worden.

Vers van de pers! AlphaGeometry.

https://twitter.com/GoogleDeepMind/status/1747651817461125352

Google lost het op door combinatie van language model met een “symbolic deduction engine”

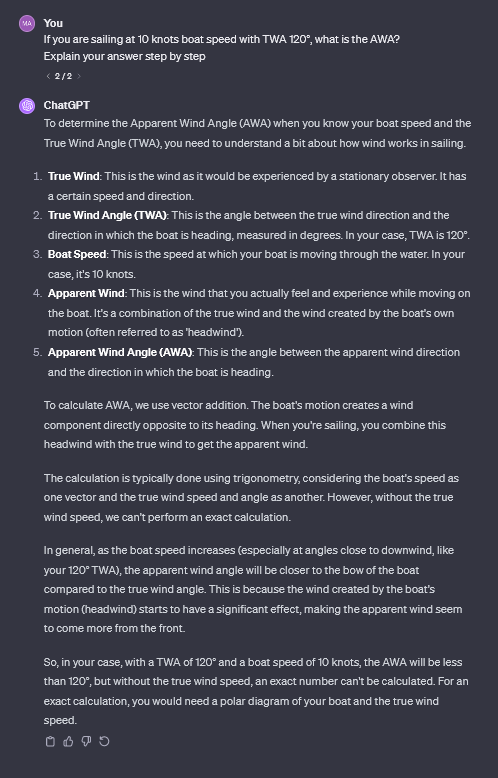

Ik krijg gemengde resultaten, maar ken ook niks van zeilen dus moeilijk in te schatten welke correct zijn ![]()

Dit met ChatGPT:

Dit met Bard: https://g.co/bard/share/30f5b726a3a8

Spijtig dat je het nog zelf moet deployen met de Github code, maar klinkt veelbelovend!

In tegenstelling tot het antwoord dat ik kreeg, is dit antwoord correct - maar het blijft vaag. In principe heeft chatGPT gelijk dat je de true wind speed en de polar van de boot moet kennen, maar eigenlijk kan je uitgaande van het feit dat deze boot in kwestie 10 knopen vaart met een true wind angle van 120° wel een inschatting maken van die 2 en zou je uit moeten komen op een AWA van om en bij de 90°. Maar in elk geval al goed dat chatGPT hier geen fout antwoord gaf, zoals die custom GPT van mij.

In dat opzicht vond ik het antwoord van Bard ook beter, omdat hij een inschatting maakte en met een concreet antwoord kwam.

Hoe dan ook, de belangrijkste boodschap blijft dat, ongeacht voor welke toepassing je AI zou gebruiken, het altijd verstandig is om de antwoorden zelf nog te controleren en niet alles als 100% correct te beschouwen. ![]()

Inderdaad, het belangrijkste is dat je goed de technologie begrijpt van de tool die je aan het gebruiken bent.

Bvb. Het feit dat ChatGPT een taalmodel is en eigenlijk gewoon woord per woord aan elkaar breit op basis van de statistiek van welke woorden in de dataset waarop getraind werd vaak bij elkaar in de buurt voorkomen.

Zo’n systeem is gewoon niet in staat om berekeningen uit te voeren.

Het kan je wel uitleggen hoe je de berekening moet doen, maar dan heb je dus nog een “logische unit” nodig die de berekening effectief uitvoert volgens de regels van de wiskunde.

Ofwel doe je dat zelf, ofwel doe je zoals AlphaGeometry en zet je er een rule-based (dus geen AI blackbox of neuraal netwerk) systeem achter.

GPT-4 kan wel zelf al (simpele) code schrijven & die laten uitvoeren. Zo heeft ChatGPT om mijn vraag op te lossen (de 2 keer, na mijn correctie en nu dus met de correcte formule) onderstaande Python code gebruikt om tot de oplossing van 90° te komen:

Correcting the calculation for Apparent Wind Angle (AWA)

Since the boat is moving, the apparent wind comes more from the front. Hence, AWA should be smaller than TWA.

In our previous calculation, we found the AWS (Apparent Wind Speed)

Now, we use the law of cosines again to find the AWA, but considering the adjustment for the forward shift

cos(AWA) = (AWS^2 + boat_speed_mps^2 - wind_speed^2) / (2 * AWS * boat_speed_mps)

cos_AWA = (AWS_squared + boat_speed_mps2 - wind_speed2) / (2 * AWS * boat_speed_mps)

AWA_corrected = math.degrees(math.acos(cos_AWA))

Ensure AWA is in the correct quadrant

if TWA > 180:

AWA_corrected = 360 - AWA_corrected

AWA_corrected

Ok, maar nu kan je het resultaat controleren omdat je de oplossing al kent.

Als je de oplossing al kent heb je de tool niet meer nodig.

Je hebt geen enkele garantie dat de voorgestelde berekening ook correct is voor andere windrichtingen. En geen enkele garantie dat er voor nieuwe vraagstukken (waar je het antwoord nog niet op voorhand van kent) een correcte berekening gaat uitrollen.